Il mondo attuale è sempre più dominato dall’Intelligenza Artificiale (IA). Ne abbiamo esempi in diversi ambiti, da quello industriale a quello medico fino alle applicazioni nei settori della sicurezza e della difesa. Se da un lato questa tecnologia e le sue molteplici forme aprono la porta al progresso e allo sviluppo di nuove e superiori capacità, dall’altro pongono domande di natura etica e legislativa. Manca, infatti, un impianto normativo comune e condiviso, al quale si aggiunge la necessità di garantire il rispetto della privacy e dei diritti fondamentali.

L’Unione Europea, dunque, si sta muovendo nell’ottica di colmare tale gap normativo e definire delle linee guida che orientino l’azione dei vari Paesi membri e possano anche fornire una base per azioni a livello internazionale. In questo breve articolo,vedremo quali sono i pilastri su cui si basa l’approccio europeo e i primi passi fatti in ambito regolamentare.

Eccellenza e Affidabilità

L’approccio europeo si basa su due concetti principali: eccellenza e affidabilità.

Quando parliamo di eccellenza, parliamo di centri di ricerca, piccole e medie imprese, grandi industrie attive nel settore dell’intelligenza artificiale che investono e lavorano per portare il nostro continente ad essere competitivo a livello globale. Lo sviluppo e l’impiego di tecnologie basate sull’intelligenza artificiale dovrà, portare beneficio non solo al comparto business, ma anche al singolo cittadino: di conseguenza, l’interazione tra ricerca, industria e cittadino è di fondamentale importanza per assicurare che i percorsi intrapresi possano effettivamente rispondere alle esigenze di mercato e società. Essenziale, dunque, assicurare anche una continua e costruttiva collaborazione tra i diversi settori e la costruzione di solide partnership specialmente tra quei settori dove l’impatto dell’intelligenza artificiale sarà più significativo (e.g. ICT, salute, difesa ecc.).

Per quanto riguarda il concetto di affidabilità (trustworthiness), è importante chiarire come questo requisito sia soddisfatto dalla compresenza di tre diversi elementi: legalità, eticità e robustezza. Legalità in quanto l’intelligenza artificiale deve ottemperare a tutte le leggi e i regolamenti applicabili: comprensibile, dunque, la complessità di definire un framework normativo che tenga in considerazione le specificità legislative anche dei singoli paesi membri. In secondo luogo, l’eticità, poiché l’utilizzo di applicazioni di intelligenza artificiale deve avvenire nel pieno rispetto e adesione ai principi e ai valori etici. Infine, robustezzasia a livello tecnico che sociale, in quanto vi è la consapevolezza che le tecnologie basate sull’intelligenza artificiale possonocausare danni non intenzionali.

Ciascuno sviluppo nell’ambito dell’intelligenza artificiale, dunque, deve e dovrà tenere conto di questi principi. Nell’ottica di promuovere l’eccellenza nel settore, la Commissione Europea, in accordo con i Paesi Membri, ha proposto di unire gli sforzi sia a livello di policy making che di investimenti. È stato, quindi, stilato un Piano Coordinato (Coordinated Plan on Artificial Intelligence) che definisce l’approccio comunitario per accelerare il progresso e allineare gli stati circa le azioni prioritarie da intraprendere nel settore.

Per quanto riguarda la trustworthiness, invece, la Commissione ha proposto tre iniziative legislative correlate, che dovranno contribuire a creare un ambiente sicuro e favorevole all’innovazione per gli sviluppatori e gli utenti finali: un quadro giuridico europeo per l’IA per affrontare i diritti fondamentali e i rischi per la sicurezza specifici dei sistemi di IA; norme dell’UE per affrontare le questioni di responsabilità relative alle nuove tecnologie (compresi i sistemi di intelligenza artificiale); una revisione della normativa di settore in materia di sicurezza (es. regolamento macchine, direttiva sulla sicurezza generale dei prodotti).

Inoltre, l’Unione ha istituito diversi comitati e gruppi volti ad occuparsi di tematiche relative allo sviluppo, l’applicazione e l’utilizzo di tecnologie basate sull’intelligenza artificiale al fine di monitorare gli sviluppi e soprattutto il potenziale impatto a molteplici livelli, dal sociale all’etico.

Verso un regolamento europeo sull’intelligenza artificiale

L’iter verso l’istituzione di un sistema regolatorio riguardante l’uso di tecnologie basate sull’intelligenza artificiale è sicuramente arduo, dovuto in parte alla complessità dell’ambito (una prima difficoltà è una stessa definizione circa cosa sia o non sia intelligenza artificiale) in parte alla necessità di far convergere gli interessi di 27 paesi membri, tenendo in considerazione le peculiarità nazionali e anche possibili ostacoli legati alle normative vigenti.

Il lavoro a livello europeo sta procedendo a buon ritmo sin dal marzo del 2018, con molteplici iniziative e proposte. In questo articolo, presentiamo nello specifico due documenti significativi e di fondamentale importanza per la definizione del futuro framework normativo. Il primo documento contiene gli Orientamenti Etici Per Un’IA Affidabile (Ethics guidelines for trustworthy AI); il secondo, una proposta di legge europea sull’intelligenza artificiale (Communication from the EC: Fostering a European approach to Artificial Intelligence).

Le Ethics guidelines for trustworthy AI definiscono il quadro di riferimento per realizzare un’IA affidabile. Delle tre componenti sopra elencate, queste linee guida si occupano principalmente di eticità e robustezza, tralasciando, invece, l’aspetto legale. Il documento è strutturato in tre capitoli che definiscono, rispettivamente, i principi base di un’IA affidabile, i requisiti necessari per realizzarla e i criteri per la valutazione.

Per quanto riguarda i principi base, il documento sancisce che lo sviluppo, la distribuzione e l’utilizzo di sistemi e applicazioni di intelligenza artificiale debba avvenire nel rispetto di alcuni diritti fondamentali (tra cui il rispetto della dignità umana, la libertà individuale, l’uguaglianza, la non discriminazione e la solidarietà, ecc.) e quattro principi etici: il rispetto dell’autonomia umana, laprevenzione dei danni, l’equità e l’esplicabilità. In secondo luogo, viene sottolineata l’importanza di prestare particolare attenzione alle categorie più vulnerabili, come bambini, persone con disabilità e altri gruppi storicamente svantaggiati o a rischio di esclusione. Come già sottolineato, lo sviluppo tecnologico in ambito IA può sicuramente portare enormi benefici ma potrebbe altresì determinare effetti negativi su tutta o una parte della società.

In termini di requisiti necessari per realizzare un’IA affidabile, ne vengono elencati sette: 1) intervento e sorveglianza umani; 2) robustezza tecnica e sicurezza; 3) riservatezza e governance dei dati; 4) trasparenza; 5) diversità, non discriminazione ed equità; 6) benessere sociale e ambientale e 7) accountability. Inoltre, viene ribadita l’importanza di considerare metodi tecnici e non tecnici per l’attuazione di tali requisiti, nonché di garantire una comunicazione chiara e aperta con gli utilizzatori e i portatori di interesse.

Infine, viene definita una lista di controllo per valutare l’affidabilità dell’IA nelle fasi di sviluppo, distribuzione o utilizzo dei sistemi di IA e adattarla allo specifico caso d’uso in cui il sistema è applicato. Tale lista non ha la pretesa di essere esaustiva ma viene vista come un documento vivo, figlio di un processo continuo di individuazione e attuazione dei requisiti, valutazione delle soluzioni e miglioramento dei risultati durante l’intero ciclo di vita del sistema di IA.

Il secondo documento, invece, rappresenta una proposta presentata dalla Commissione Europea al Parlamento, al Consiglio, al Comitato economico e sociale e al Comitato delle Regioni per promuovere un approccio europeo all’intelligenza artificiale, che permetta di sfruttare le opportunità che derivano dall’utilizzo di questa tecnologia ma che prenda altresì in considerazione i potenziali rischi e definisca metodi e soluzioni per affrontarli. Tale documento dovrebbe, dunque, porre le basi per una futura legge europea sull’intelligenza artificiale, l’EU AIAct.

La proposta presentata dalla Commissione fornisce, anzitutto, una definizione dell’espressione intelligenza artificiale, indicandola come “una famiglia di tecnologie in rapida evoluzione in grado di apportare una vasta gamma di benefici economici e sociali in tutto lo spettro delle attività industriali e sociali. L’uso dell’intelligenza artificiale, garantendo un miglioramento delle previsioni, l’ottimizzazione delle operazioni e dell’assegnazione delle risorse e la personalizzazione dell’erogazione di servizi, può contribuire al conseguimento di risultati vantaggiosi dal punto di vista sociale e ambientale nonché fornire vantaggi competitivi fondamentali alle imprese e all’economia europea”. Tale definizione è appositamente stilata in modo da poter includere anche tecniche e approcci futuri, ovvero non ancora conosciuti o implementati.

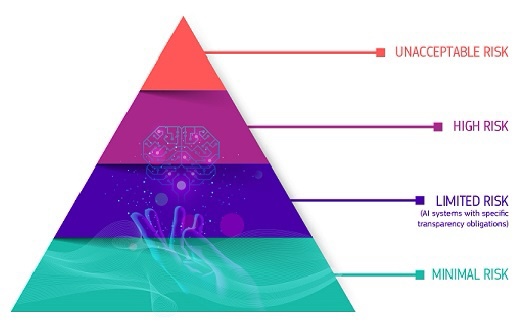

In secondo luogo, la proposta fissa delle regole comuni per lo sviluppo, l’immissione sul mercato e l’utilizzo di sistemi di IA nell’Unione seguendo un approccio proporzionato basato sul rischio. Vengono, infatti, individuate quattro categorie di rischio utilizzate per mappare le diverse applicazioni di intelligenza artificiale: la prima categoria include quelle tecnologie e quei sistemi che pongono un livello inaccettabile di rischio, come i sistemi di assegnazione di “credito sociale” utilizzati in Cina. Applicazioni ad alto rischiocomprendono, invece, strumenti per la selezione automatica dei curricula durante i processi di selezione del personale. Una terza categoria comprende applicazioni e sistemi a rischio limitato, per i quali, cioè, sono necessari specifici obblighi di trasparenza, ovvero l’utente deve essere consapevole che sta interagendo con una macchina e poter scegliere se proseguire o tornare indietro (e.g. chatbot). Infine, un’ultima categoria comprende tutte quelle applicazioni a rischio minimo o nullo, per le quali non vi è esplicito divieto o che non sono considerate ad alto rischio.

L’attenzione principale è, chiaramente, rivolta alle prime due categorie, in quanto rappresentano quelle che possono avere l’impatto più significativo sul singolo individuo e sulla società e necessitano in modo prioritario una regolamentazione. Vengono, infatti, definite delle regole applicabili alle fasi di design, sviluppo e utilizzo di certi sistemi ad alto rischio. La proposta prevede che tali sistemi rispettino specifici requisiti tra cui l’utilizzo di datasets qualitativamente elevati, la definizione di un’appropriatadocumentazione per facilitare la tracciabilità, la condivisione delle informazioni con gli utilizzatori, misure per il monitoraggio umano e i più elevati standard in termini di robustezza, sicurezza, accuratezza e cybersecurity.

La proposta, inoltre, mette al bando specifici sistemi che sono ritenuti in collisione con i valori dell’Unione o che violano i dirittifondamentali. Tali sistemi includono tecniche che portano alla distorsione del comportamento personale o che sfruttano vulnerabilità individuali, potendo, così, causare danni fisici o psicologici. Restrizioni sono poste, invece, all’uso di determinati dispositivi, ad esempio i sistemi per l’identificazione biometrica remota a fini di attività di contrasto, stabilendone un generale divieto per l’utilizzo real-time negli spazi pubblici salvo casi eccezionali autorizzati dalla legge. Inoltre, la proposta di legge prevede anche disposizioni per aumentare la trasparenza e minimizzare i rischi per la sicurezza e la potenziale violazione dei diritti fondamentali.

La proposta è stata presentata e discussa in Parlamento e i diversi membri stanno presentano i propri commenti e richieste di emendamenti al testo. Sicuramente il percorso per l’istituzione di un framework comune è ancora lungo e necessità di una forte collaborazione non solo tra i paesi membri ma anche tra i diversi settori: di certo, l’Unione sta dimostrando una notevole attenzione verso la tematica e un intento concreto nel definire un impianto regolatorio e degli standard che possano anche essere d’ispirazione anche al di là dei confini dell’Unione.

Bibliografia

European Commission. “A European approach to artificial intelligence”. Disponibile su https://digital-strategy.ec.europa.eu/en/policies/european-approach-artificial-intelligence [ultimo accesso 01/05/2022].

European Commission. “Regulatory framework proposal on artificial intelligence”. Disponibile su https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai [ultimo accesso 01/05/2022].

Commissione Europea. Proposta di Regolamento del Parlamento Europeo e del Consiglio che stabilisce regole armonizzate sull’intelligenza Artificiale (Legge sull’intelligenza Artificiale) e modifica alcuni atti legislativi dell’Unione, 21/04/2021. Disponibile su https://eur-lex.europa.eu/resource.html?uri=cellar:e0649735-a372-11eb-9585-01aa75ed71a1.0006.02/DOC_1&format=PDF [ultimo accesso 01/05/2022].

Future of Life Institute (FLI). “The Artificial Intelligence Act”.Disponibile su https://artificialintelligenceact.eu/ [ultimo accesso 01/05/2022].